La Data est-elle la panacée face aux épidémies ?

Depuis la fin du XIX siècle, les analyses réalisées sur les épidémies mortelles amènent une question récurrente : qu’aurions-nous pu faire pour réagir plus vite, à défaut de prévoir l’infection ? Pour détecter plus rapidement les premiers signes, pour isoler au plus vite les patients contagieux, pour sauver des centaines, parfois des milliers de personnes ? Le problème est global.

Les maladies infectieuses font partie des risques majeurs pour l’humanité selon le World Economic Forum de Davos et le sujet est d’ailleurs brulant d’actualité : Ebola, Zika, Coronavirus. Et en la matière, la gestion de la donnée, semble être au centre de la réponse que nous pourrions apporter.

Un peu d’histoire

L’étude des causes et de la propagation des maladies prend racine dans les grandes vagues épidémiques du choléra à Londres, dans les années 1850, via notamment les travaux du médecin anglais : John Snow. Celui-ci, en plaçant sur une carte de Londres les foyers infectieux, avait mis en évidence une corrélation entre la maladie et les stations de pompage de l’eau de ville. Il en avait alors établi que l’eau était le vecteur de propagation, et non pas l’air comme le voulait la théorie. Une illustration d’une discipline que nous appelons aujourd’hui Datavisualisation.

Depuis, la méthodologie utilisée en épidémiologie a évolué et se trouve désormais à la croisée de nombreuses disciplines, biologie, sciences humaines mais aussi statistiques et data science. Pour utiliser des termes que l’on rencontre en entreprise, il s’agit d’analytics c’est-à-dire un mélange de problématiques métier (médecine, finance, RH) et techniques (Big Data, Informatique, …).

L’épidémiologie a donc subi des transformations similaires aux entreprises : Le développement d’une approche Data Centric, tournée vers la donnée, celle-ci mise au centre pour piloter et pour agir, pour prévoir et pour analyser. On parle désormais d’IA, de modèles prédictifs de propagation des épidémies, … Mais comme dans les entreprises, la réalisation est beaucoup plus complexe et le passage de simple prototype à une vraie application industrialisée présente des défis.

L’analyse des signaux faibles

Une des principales problématiques rencontrées quand on cherche à modéliser un phénomène est la réduction des facteurs de causalité. Plus le nombre de paramètres est important dans un calcul, plus celui-ci devient difficile et long à réaliser. L’amélioration des techniques de calcul, ce qu’on a appelé la révolution Big Data, a permis de lever en partie cette barrière et d’intégrer les paramètres que l’on pensait jusqu’ici peu influents ou de détecter via des moyens non conventionnels, les signaux faibles. Une des premières pistes sur laquelle se sont penchés les épidémiologues a été l’analyse des réseaux sociaux. En se basant sur des symptômes décrits par la population sur Twitter, Facebook, … il est possible d’en diagnostiquer la maladie. On peut ainsi détecter l’émergence d’une maladie ou d’en contrôler la propagation sans rencontrer physiquement les patients.

Le sujet avait notamment été adressé pour la grippe par Google Flue Trend, en se basant sur les résultats du moteur de recherche éponyme. Une expérimentation arrêtée depuis 2015 : le modèle n’était pas assez précis, trop sensible à des facteurs externes (psychologiques, médias, …) ; la publication par exemple d’un article traitant de la grippe dans un journal national faisait augmenter le nombre de recherches sur les symptômes, trompant l’algorithme qui pensait avoir à faire à une explosion du nombre de malades.

Mais l’idée a été reprise par d’autres entreprises qui croisent les données de Twitter ou Wikipedia avec d’autres sources. Ainsi la société Blue Dot a déclaré avoir détecté l’émergence du coronavirus bien avant les annonces faites par l’OMS.

L’IA ne remplacera pas les médecins demain. Les analyses des signaux faibles ne sont qu’une aide à la décision, un avis complémentaire qui pourrait pousser les experts à s’intéresser à une région en particulier, à croiser les informations avec une véritable analyse scientifique.

IOT, QY et éthique

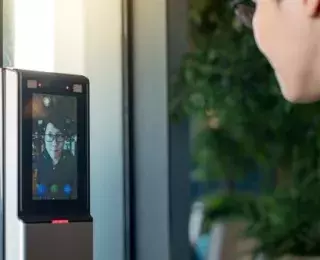

La détection des pandémies par des signaux faibles a été mis en avant dans les médias pour le côté spectaculaire : Détecter une épidémie de grippe avec Twitter ou Google Maps parait particulièrement impressionnant. Mais une nouvelle technologie, récente elle aussi parait tout aussi prometteuse. C’est celle de l’IOT et du QY (quantified yourself ou mesure de soi) : montres connectées, smartphone, … autant d’objets du quotidien qui se renseignent sur notre état de santé comme le poids, la température, le rythme cardiaque. De ces données, les épidémiologistes peuvent dresser une cartographie de la population et se baser ici sur des données plus « objectives » que 280 caractères sur un réseau social.

Mais un tel profiling amène évidement une problématique d’éthique : quelle limite poser dans la collecte d’informations personnelles (données sensibles, pour le RGPD), même si la finalité est ici la santé publique. Comment s’assurer de la protection de ces informations, et qu’elles ne seront pas utilisées par des personnes tierces ? Une fois encore, les entreprises ont déjà été confrontées à de telles problématiques regroupées généralement sous le nom de la ‘gouvernance des données’ ?

Par extension, on peut regrouper dans ce terme également d’autres problématiques : gestion de la qualité, du cycle de vie de la donnée, définition de référentiels, management des interfaces pour s’assurer que tout le monde puisse échanger et comprendre plus facilement l’information. Ce sont des sujets que l’on trouve couramment traités dans de nombreux secteurs et qui pourraient être sources d’amélioration pour la gestion des données de santé.

Pour la création d’un acteur de la santé publique et de l’IA

La santé publique est un enjeu majeur pour les gouvernements, à ce titre la donnée doit également l’être. Les problématiques éthiques sont importantes, la coordination inter-disciplinaire est nécessaire, les compétences sont difficiles à trouver. Les événements d’Ebola ont mis en évidence une défaillance des organisations internationales qui ont mis près de 5 mois pour annoncer l’état d’alerte, alors même que le délai de prudence avait été passé. Pour autant des acteurs externes avaient déjà levé les alertes.

A ce titre, il parait nécessaire de créer un acteur public qui pourrait traiter et développer les sujets data en lien avec les entreprises privées habituées à ces problématiques d’analyse et de gouvernance tout en assurant une coordination globale et le respect dans l’utilisation des données.

Il ne faut néanmoins ne pas se tromper et attendre de la donnée ce qu’elle ne saurait apporter : si l’apport des techniques d’analyse pourrait être utile, elles ne sauraient en aucun cas remplacer le rôle d’un médecin dans le contrôle et l’évaluation de la santé d’un individu.

Christophe de BOISSET