L’essor de l’IA générative remet-il en cause la fiabilité des systèmes biométriques ?

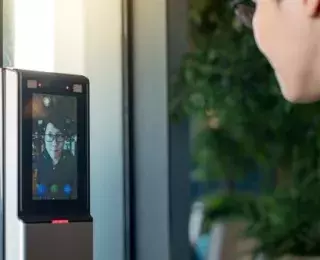

L’authentification biométrique s’est imposée depuis une décennie comme un pilier de la sécurité numérique. Empreintes digitales, reconnaissance faciale, vocale ou même comportementale sont aujourd’hui massivement utilisées dans les smartphones, les services financiers, les accès aux bâtiments sensibles ou les systèmes d’information critiques.

Reposant sur l’unicité des caractéristiques physiques de chaque individu, la biométrie offre a priori une solution robuste et pratique, bien plus difficile à contourner que les mots de passe ou les dispositifs d’authentification à facteur unique. Elle s’inscrit aussi dans une logique d’expérience utilisateur optimisée : fluidité, rapidité, réduction du recours à des éléments mémorisés ou portés.

Cependant, cette confiance dans la biométrie est aujourd’hui mise à l’épreuve par les progrès spectaculaires de l’intelligence artificielle générative. Deux domaines en particulier suscitent des inquiétudes : les deepfakes et l’IA adversariale.

L’authentification biométrique, une révolution en danger

La biométrie s’est imposée comme une solution sûre et sans friction d’authentification. En 2022, 81% des smartphones l'utilisent, un chiffre en constante progression. Les promesses de la biométrie reposent sur l’unicité des caractéristiques humaines.

Cependant, la réalité de terrain révèle plusieurs limites notables :

- Taux d’erreur persistants : faux positifs (acceptation d’un intrus) et faux négatifs (refus d’un utilisateur légitime) restent fréquents et nuisent à la fois à l’expérience utilisateur et à la fiabilité du système.

- Techniques de contournement relativement simples dans certains cas : photos haute résolution, masques imprimés en 3D ou reproductions audio ont déjà permis de tromper des systèmes grand public.

- Irrévocabilité des données : contrairement à un mot de passe, une empreinte digitale ou un visage ne peuvent pas être “modifiés” en cas de fuite. La compromission des données biométriques est donc définitive.

- Failles d’infrastructure : stockage centralisé, défauts de chiffrement, et architecture cloud mal sécurisée peuvent exposer des millions d’identifiants biométriques à des compromissions. En 2015, une cyber-attaque visant l’Office of Personnel Management a mené au vol de 5,6 millions d’empreintes digitales.

- Enjeux liés à l’hébergement des données :

- Authentification locale : plus sûr, mais coûteux à maintenir.

- Authentification cloud : accessible et flexible, mais soulève des enjeux de souveraineté et de contrôle des données (notamment si l’hébergeur est à l’étranger).

Ces constats mettent en lumière un paradoxe majeur : plus les données biométriques sont adoptées, plus elles deviennent des cibles stratégiques. La promesse d’une sécurité “innée” est donc remise en question.

Quand l’IA devient l’arme des attaquants

En trois ans, les attaques par deepfake ont été multipliées par vingt. Les avancées de l’IA générative bouleversent les hypothèses traditionnelles sur la sécurité biométrique. Trois aspects méritent une attention particulière.

1. Les deepfakes et le spoofing vocal : imitations de plus en plus crédibles

Les vidéos ou enregistrements audio générés par IA permettent aujourd’hui d’imiter avec précision un visage ou une voix. Ces contenus peuvent tromper des systèmes de reconnaissance vocale ou faciale, surtout s’ils sont peu entraînés ou mal configurés.

Un exemple concret de “spoofing vocal” : en 2019, une entreprise britannique a été victime d’un deepfake vocal qui a permis de soutirer près de 250 000 $ à l’aide d’un appel frauduleux imitant un dirigeant.

2. Les limites des systèmes de détection actuels

La majorité des algorithmes biométriques en production n’ont pas été conçus pour détecter des contenus synthétiques. Résultat : un deepfake vidéo bien construit, ou un fichier audio généré à l’identique, peut suffire à contourner la vérification.

Des chercheurs en cybersécurité ont démontré à plusieurs reprises (lors de conférences telles que Black Hat ou DEFCON) la vulnérabilité de certains dispositifs, notamment via des techniques de spoofing ou d’injection de samples générés.

3. L’IA adversariale

Une autre menace émerge : les attaques par perturbation subtile. En modifiant légèrement une image (par exemple, via des motifs imprimés ou des accessoires), il est possible de leurrer un algorithme de reconnaissance faciale. Ces attaques dites “adversariales” ne nécessitent pas forcément une simulation complète du visage : elles exploitent les failles du modèle d’IA en déstabilisant le modèle de reconnaissance lui-même.

Par exemple, des chercheurs de la société Black Hat ont réussi à tromper le système FaceID de façon très simple à l’aide de simples lunettes modifiées et de morceaux de carton stratégiquement placés.

Quelles pistes pour sécuriser l’authentification biométrique ?

Cette technologie demeure précieuse pour l’authentification : rapide et intuitive, elle permet une vérification fluide. Mais elle doit aujourd’hui être renforcée par des pratiques adaptées à ce nouveau contexte technologique.

Généraliser l’authentification multifactorielle

L’authentification biométrique ne doit plus être utilisée seule. La combinaison avec des facteurs de possession (token, téléphone), ou de connaissance (code PIN), devient incontournable.

Intégrer l’IA à la défense

Des systèmes de détection de deepfake ou d’analyse comportementale commencent à émerger :

- IA anti deepfake (Elles permettent de repérer les anomalies dans les contenus générés) :

- Analyse de la texture de peau et des jeux de lumière

- Vérification de la synchronisation labiale

- Identification de micro-mouvements impossibles à générer artificiellement

- Modèles adaptatifs : les systèmes apprennent les comportements de l’utilisateur (frappes clavier, mouvements de souris, localisation) et déclenchent une alerte ou une vérification supplémentaire si un usage paraît suspect.

Ces technologies peuvent renforcer les contrôles existants, à condition d’être bien intégrées aux workflows métier.

Cadre réglementaire

Les données biométriques bénéficient d’un cadre juridique spécifique et renforcé sous le Règlement général sur la protection des données (RGPD), car elles sont considérées comme une catégorie particulière de données, dites données sensibles. Leur traitement est interdit par principe, sauf exceptions strictement encadrées, telles que le consentement explicite, l’intérêt public important, ou la protection des intérêts vitaux, entre autres.

Même lorsqu’une exception prévue à l’article 9 du RGPD autorise le traitement de données biométriques, celui-ci doit toujours respecter les six principes généraux du RGPD, à savoir : la licéité, la loyauté et la transparence ; la limitation des finalités ; la minimisation des données ; l’exactitude ; la limitation de la conservation ; et l’intégrité et la confidentialité (sécurité des données).

En France, la Commission nationale de l'informatique et des libertés (CNIL), autorité administrative en matière de protection des données personnelles, encadre encore plus strictement l’utilisation des données biométriques dans certains contextes, notamment pour le contrôle d’accès aux lieux de travail, aux établissements scolaires ou aux espaces publics.

Enfin, le traitement de données biométriques nécessite, dans la majorité des cas, une Analyse d’Impact relative à la Protection des Données (AIPD), dès lors qu’il est considéré comme présentant un risque élevé pour les droits et libertés des personnes.

Renforcer, réguler, réinventer : l’avenir de la biométrie

L’essor fulgurant de l’IA générative bouleverse profondément les fondations sur lesquelles reposait la confiance dans les systèmes biométriques. Si ces technologies ont longtemps été perçues comme des garanties de sécurité à la fois robustes et ergonomiques, leur vulnérabilité face aux deepfakes, aux attaques adversariales et aux failles systémiques remet en cause leur statut de solution infaillible.

Dès lors, la biométrie ne peut plus être envisagée comme une protection autonome : elle doit désormais s’intégrer dans une approche de sécurité multicouche, combinant authentification multifactorielle, détection avancée des manipulations, et adaptation continue des modèles. Ce renforcement technologique doit impérativement s’accompagner d’un strict respect du cadre réglementaire pour garantir la confidentialité et la protection des données sensibles.

La biométrie reste un levier puissant — à condition d’en reconnaître les limites, d’en anticiper les dérives et de repenser son usage à l’ère de l’intelligence artificielle.

Le sujet vous intéresse ? Nos experts vous répondent

La cybersécurité est devenue incontournable dans le monde numérique. Les entreprises sont confrontées à des risques croissants liés aux cyberattaques et aux intrusions malveillantes. Chez mc2i, nous comprenons ces défis et nous sommes déterminés à aider nos clients à se protéger efficacement contre ces menaces.