Intelligence artificielle le tribut énergétique du deep learning

Depuis les années 2000, l’amélioration exponentielle des capacités de calculs des ordinateurs a entraîné l’émergence du deep learning, ou apprentissage profond, comme outil révolutionnaire d’entraînement d’une Intelligence Artificielle (IA). Assistants virtuels, reconnaissance faciale, chatbots, traitement naturel du langage… De nombreux exemples d’innovations technologiques s’appuient aujourd’hui sur des algorithmes d’apprentissage profond pour effectuer de la prise de décisions.

Lorsque l'on pense à la consommation énergétique d’une IA, on résume souvent cela à la consommation à l’usage : par exemple, lors d’un échange en direct avec un chatbot, quelle quantité d’énergie (en consommation électrique) est nécessaire pour faire fonctionner ce dernier. Cependant, cette dernière n’est que la partie émergée de l'iceberg - il est intéressant de se pencher également sur l’impact environnemental du développement d’une IA.

Deep learning : des prérequis énergivores

Revenons en premier lieu sur la notion d’apprentissage profond. Cela consiste à demander à une machine d’apprendre et d’arriver à un résultat sans qu’on lui apporte des connaissances préalables. Pour cela, il est nécessaire de fournir à l’IA un large ensemble de données en amont, lorsqu’elle n’est pas encore savante. Ce processus s’étale sur plusieurs jours et nécessite parfois plusieurs itérations pour arriver au niveau de satisfaction souhaité.

Par ailleurs, les algorithmes sont beaucoup plus performants et complexes aujourd’hui qu’il y a une dizaine d’années, et le phénomène ne cesse de s’accélérer. Le volume de données nécessaire à l’apprentissage est en croissance constante et sans limite. En conséquence, ces algorithmes requièrent un matériel physique de plus en plus performant, pour effectuer les quelques milliards de calculs nécessaires chaque jour. Quelques millions de kilowattheures dépensés par des machines équipées de quelques dizaines de milliers de processeurs. (en comparaison, avec 1 kWh, on peut faire fonctionner son réfrigérateur combiné pendant une journée).

La convergence entre le besoin d’un grand volume de données pour l’apprentissage de l’IA et la nécessité d’un support physique à la pointe de la technologie induit donc de lourdes conséquences pour la planète.

La facture énergétique du deep learning

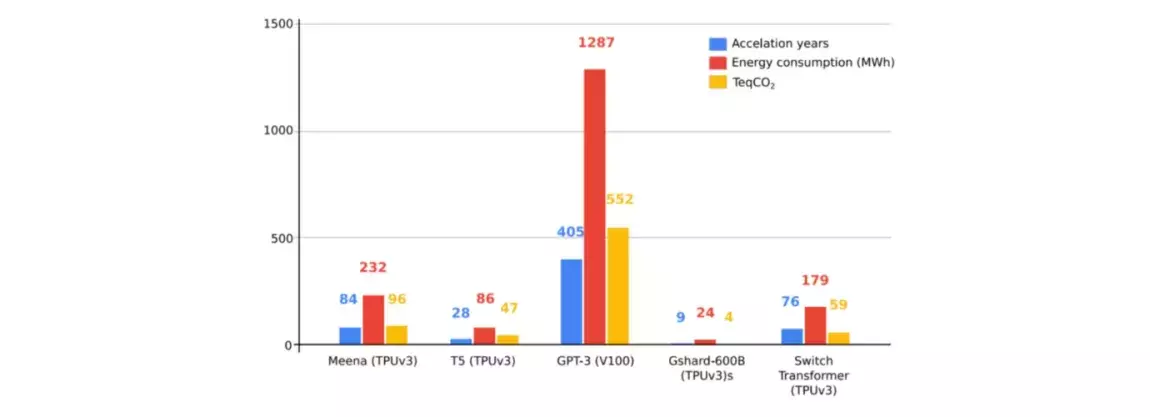

Voyons comment ces observations se traduisent en termes de chiffres. Ci-dessous, quelques facteurs d’énergie utilisés pour l’entraînement de plusieurs réseaux de neurones modernes pour le traitement naturel du langage :

Prenons l’exemple du modèle de langage GPT-3, développé par la société OpenAI, le plus gros modèle de langage jamais entraîné (175 milliards de paramètres). L’entraînement de ce modèle consommerait autour de 552 TeqCO2. A titre de comparaison, 1TeqCO2 équivaut à un aller / retour Paris – New York en avion. Point supplémentaire : le maximum annuel autorisé à chaque Européen pour atteindre l’équilibre carbone en 2050 serait de 2TeqCO2. Le coût d’entraînement de ce modèle serait en moyenne 250 fois supérieur à cette valeur.

Évoquons aussi les résultats en unités de puissance : le cerveau humain consommerait en un mois environ 12 kilowattheures pour des tâches plus complexes que le traitement naturel du langage, soit 1000 fois moins que les 1287 MWh annoncés pour l’entraînement de GPT-3 …

Cela remet ainsi en perspective la pertinence de certains outils du quotidien utilisant de l’IA.

La nécessité de repenser le besoin d’IA

L'enjeu pour les années à venir est donc la sensibilité de tous les métiers gravitant autour de l’IA à ces questions d’impact énergétique. Plusieurs leviers sont d’ores et déjà identifiés pour réduire ce dernier.

Les premiers concernent les développeurs. En effet, former ces derniers aux enjeux énergétiques de l’IA pourrait permettre de réduire le nombre de cycles d’entraînement lancés lors d’une phase d’apprentissage. L’idée serait de privilégier des cycles de qualité plutôt que des cycles en quantité. En outre, les bonnes pratiques d’écoconception s’appliquent aussi au développement d’une IA. Par exemple, pour stocker la donnée, on peut privilégier des data centers hébergés dans des pays où l’impact carbone de la production d’électricité est faible, et limiter la volumétrie des échanges.

Les suivants, et peut-être les plus importants, concernent les décisionnaires et les équipes opérationnelles. L’IA est une technologie efficace pour rationaliser des processus de production ou encore donner naissance à des initiatives pour lutter contre la pollution de nos écosystèmes (comme le projet The Ocean Cleanup). Pour autant, un algorithme d’apprentissage profond de dernier cri est-il nécessaire pour tracker les consommateurs dans un supermarché et leur permettre de ne plus passer à la caisse ?

Ainsi, il est important de se poser la question de la nécessité de l’emploi d’une technologie donnée à chaque nouveau projet, et à chaque étape d’un nouveau projet. L’IA se doit d’être un outil améliorant notre quotidien, et possède toutes les capacités pour. Cependant, il faut remettre en question la tendance actuelle du « tout à l’IA ». Il faut repenser ce qui relève du besoin (les 3U s’appliquent aussi à l’IA : Utile, Utilisable, et Utilisé), et ce qui relève du confort, afin de corriger la trajectoire prise par la consommation énergétique globale de cette technologie aujourd’hui.

En étant sensibles à cette problématique, nous serons capables de monitorer plus finement ces dépenses énergétiques et de cibler les surcoûts. Pour conclure, citons Vincent Courboulay, Directeur Scientifique de l’Institut du Numérique Responsable : « le tout est qu’il faut avoir en permanence un œil sur la balance, pour ne pas dépenser plus que ce que l’on économise ».

Le sujet vous intéresse ? Nos experts vous répondent

L'innovation est la clé vers la réussite de la plupart des projets car nous constatons des mutations qui touchent tous les secteurs. Nous bénéficions d'une expertise technologique et méthodologique pour accompagner nos clients dans ce challenge plus que stimulant.