Excel, oui, mais jusqu’à où ?

Les innombrables fonctionnalités, la puissance et l'omniprésence d'Excel en font l'outil « par défaut » et surtout, les bases de données les plus communes que l'on puisse trouver. En 2021, les solutions Office 365 représentaient 300 millions de licence et 50 millions d'abonnés, avec une croissance annuelle du nombre d'abonnés s'élevant à 16%.

Pourtant, le chiffre d'affaires des solutions Data continue de monter : Oracle, Tableau Software, Qlik, Dataiku, Hadoop, Spark... Où est la frontière ? Pourquoi faire le pas entre Excel et des solutions plus techniques ? La question se pose assez simplement : Excel, oui, mais jusqu'à où ? Et pour quel usage ?

En octobre 2020, la nouvelle avait fait des remous dans la presse anglaise : environ 16.000 cas Covid avaient disparu des données nationales suite à une erreur de manipulation sur Excel. Par ailleurs, étant donné les liaisons entre les différents tableurs et le caractère central de ces données, cette suppression eut également pour conséquence le non-référencement de ces malades au service de dépistage de la NHS. L'ensemble des cas contacts disparus ne furent pas contactés et prévenus pour qu'ils puissent s'isoler à leur tour. Un manque de prévention qui, selon le Guardian et les estimations des deux économistes Thiemo Fetzer et Thomas Graeber, aurait empêché de prévenir environ 1500 morts et 125.000 infections supplémentaires.

Pour l'anecdote, la suppression eut lieu lors de l'export du fichier : après passage des données en CSV, elles furent enregistrées au format d'une version obsolète d'Excel ne pouvant contenir plus de 65.536 lignes. Automatiquement, les données « excédantes » furent coupées et la manipulation ne fut pas remarquée.

Aussi catastrophique que soit cette erreur, elle en évoque un ensemble d'autres. En effet, les innombrables fonctionnalités, la puissance et l'omniprésence d'Excel en font l'outil « par défaut » et surtout, les bases de données les plus communes que l'on puisse trouver. En 2021, les solutions Office 365 représentaient 300 millions de licences et 50 millions d'abonnés, avec une croissance annuelle du nombre d'abonnés s'élevant à 16%. Pourtant, le chiffre d'affaires des solutions Data continue de monter : Oracle, Tableau Software, Qlik, Dataiku, Hadoop, Spark... Où est la frontière ? Pourquoi faire le pas entre Excel et des solutions plus techniques ? La question se pose assez simplement : Excel, oui, mais jusqu'à où ? Et pour quel usage ?

Excel, oui, mais pour quel usage ?

D'abord, il y a longtemps qu'Excel ne répond plus uniquement à des besoins purement comptables tel qu'il a été originellement conçu pour. Il suffit de jeter un coup d’œil à l'ensemble de ses fonctionnalités, inconnues pour la majorité de ses utilisateurs, ainsi la variété de ses utilisations au quotidien. Stockage des données, « moulinettes » de calcul, préparation de formulaires administratifs maison, véritables dashboards de KPI, tout ceci étant grandement facilité par la possibilité de connecter des classeurs entre eux.

Impossible d'arriver dans un environnement d'entreprise et ne pas devoir prendre un temps pour comprendre l'organisation et la dissémination des multiples fichiers excel permettant, souvent faute de mieux, de faire 'tourner la boutique'. Chaque environnement est marqué par des habitudes de pratique.

Par exemple certaines formules fonctionnant selon des règles différentes et limitant les traitements ultérieurs possibles. Dans le même ordre idée, d'innombrables macros seraient mises à mal par une simple modification sur une colonne contenue dans un fichier inconnu pour la plupart de ceux qui utilisent pourtant régulièrement ladite macro.

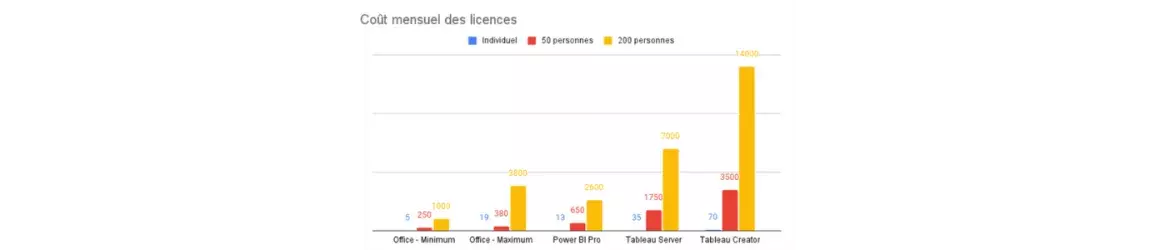

La problématique est également financière. Sans même prendre en compte les coûts éventuels liés au stockage, le coût des licences simples pour des outils de dataviz ou de data science est conséquent.

En comparant le coût mensuel d’Office, même à son tarif maximum, avec celui d’autres outils de visualisation, il devient clair qu’il s’agit d’une problématique. D’autant plus que dans le cas de Tableau, si on souhaite préparer des dashboards et les partager ensuite à un ensemble d'utilisateurs via Tableau Server, ces coûts s'accumulent.

Dans la mesure où une organisation paie la plupart du temps déjà pour Office et où il est impossible de se défaire entièrement d’Excel à l’heure actuelle, il faudra donc compter un coût supplémentaire presque aussi important (voir le double) que celui d’un abonnement à une suite Office. Sans oublier le coût de formation de ses collaborateurs à l'outil qui a été choisi... A contrario, Excel est particulièrement accessible, ne serait-ce que grâce à sa documentation interne mais aussi grâce à sa popularisation.

D'autant plus que pour un utilisateur expérimenté et aguerri, Excel permet de réaliser la plupart des tâches que l'on attribuerait habituellement au domaine des SGBD et de la data. Car Excel, au-delà d'être une solution analytique, est un écosystème à part entière, permettant extraction des données, traitement, calcul, rendu visuel et exportation, et ainsi de suite. Actuellement, aucune autre solution, même semblable comme peut l'être Google Sheets, n'offre la même variété de possibilités et surtout, la précision attendue par des utilisateurs ayant disposé d'un outil aussi précis pour la grande majorité de leur carrière. Excel s'inscrit à la fois dans un environnement mais aussi dans une culture d'habitudes : dans la transmission de compétences d'un collaborateur à un autre.

Microsoft l'a bien compris : chaque année depuis 2020, ce dernier organise par ailleurs le championnat du monde d'Excel, « Financial Modeling World Cup », réunissant des centaines de participants pour plancher sur des ensembles de calculs plus ou moins complexes jusqu'à la finale, pour un prix de 10.000 dollars. Et si l'idée pourrait paraître saugrenue, le concours est diffusé sur Youtube et la chaîne américaine de sport ESPN et rassemble quelques milliers de spectateurs.

Au-delà du comique de la chose, Microsoft a donc bien saisi que ce qui fait en grande partie la force d'Excel, en plus des considérations financières. C’est bien une culture d'habitudes, partagée entre les entreprises : et de l'habitude découle la dépendance, surtout dans un contexte où les compétences data manquent cruellement. Une dépendance que les autres distributeurs de solution ont bien du mal à contrer, comme le prouve par exemple la plainte d'OVH Cloud contre Microsoft pour abus de position dominante.

Excel, oui, mais quels risques ?

Bien encadré, l'outil est théoriquement parfaitement suffisant pour la grande majorité des pratiques. Pourquoi, après tout, s'embêter à employer un système noSQL et embaucher les ressources possédant les connaissances nécessaires pour le mettre en place, pour quelques tableaux ne contenant pas plus d'un millier d'entrées quand quelques formules ici et là font tout aussi bien le travail ? De même, pourquoi créer des plateformes de partage des données lorsque, théoriquement, un ensemble de classeurs sécurisé permettrait le même résultat ? Pour reprendre l'exemple de la suppression des données par la NHS, si jamais ces données n'avaient pas dépassé les 40.000 lignes, n'aurait-on pas pu considérer leur gestion des données comme suffisante ?

Excel, oui, mais par qui ?

D'abord, la majorité des utilisateurs d'Excel ne le maîtrisent pas, ou du moins pas techniquement. L'erreur commise par la NHS était due à une méconnaissance technique mais évoque d'autres cas qui ne datent pas d'aujourd'hui.

Dans le cas de la médiatique faillite de la société Enron en 2001, suite à des malversations financières, une chercheuse a trouvé en moyenne 750 erreurs pour 10.000 classeurs analysés, résultant à la fois de mauvais usages des utilisateurs mais également de caractéristiques propres au programme.

C'est un élément connu de n'importe quel consultant : tout le monde utilise Excel, mais personne ne sait vraiment l'utiliser. La question de la formation ou, en l’occurrence, du manque de formation, doit être évoquée.

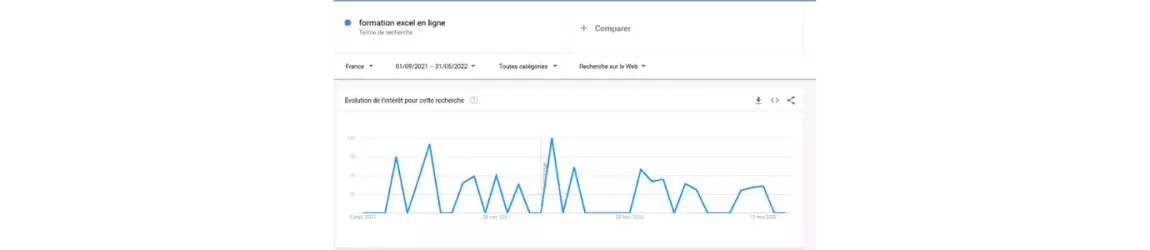

Une recherche rapide via Google Trends apporte un éclairage intéressant : en moyenne, du 1er septembre 2021 au 31 mai 2022, le nombre de recherches pour « formation Excel en ligne » oscillait entre 50 et 100 recherches par jour pour l'Ile-de-France aux 2/3 et 1/3 pour la région Auvergne-Rhônes Alpes. Les vacances scolaires d'été ont été exclues de par leur caractère spécifique, mais les creux d'activité se trouvent systématiquement durant les vacances scolaires. S'il y a peu de chances pour que les jeunes enfants et adolescents soient des aficionados d'Excel, on peut en tirer la conclusion que ces recherches sont effectuées, pour la plus grande partie, par leurs parents.

La question serait de savoir si ces derniers sont déjà salariés ou s’ils sont en recherche d'emploi : dans tous les cas, le besoin est bien là. Au moment d'écrire cet article, le moteur de recherche de Mon Compte Formation compte quelque 300 formations portant sur Excel. Power BI en comptabilise 16, et Tableau un peu moins d'une centaine.

Excel, oui, mais pour quelle sécurité ?

Car dans la question de la formation se pose aussi la question de la sécurité des données. Il faut imaginer un département d'une centaine de personnes qui se mettrait à utiliser Excel pour traiter ses données RH, comme cela peut encore être le cas dans beaucoup d'organisations. Le simple fait d'inclure un numéro de téléphone et un mail associé à un nom et à un prénom classerait déjà ce fichier comme sensible.

Comment respecter les délais de conservation limite des données lorsque l'on ne peut pas savoir quand exactement les données ont été récoltées ? Qui est tenu responsable des purges régulières ? Ces données sont-elles référencées quelque part ?

En outre, les chances pour qu'une personne non autorisée y accède sont particulièrement hautes, la plupart des fichiers Excel utilisés en entreprise ne faisant pas l'objet de processus précis quant aux habilitations. Il faut donc imaginer les dégâts potentiels si le fichier possédait des informations plus critiques encore, comme celles portant sur le salaire ou les commentaires résultant d'entretiens d'évaluation annuels.

Enfin, quid de la documentation ? La plupart des fichiers excel n'en possèdent aucune, car ne sont pas des projets à proprement parler : et là, la criticité du transfert de connaissances se pose.

L'absence de sécurité d'un tel ensemble de données donnerait des cauchemars à n'importe quel DPO. Pour rappel, en 2021, la CNIL prononçait une amende de 400.000 euros envers la RATP pour avoir récupéré des données illicites et pour des manquements aux articles 5.1 et 31 du RGPD portant sur la limite de conservation des données et le manquement à la sécurité des données. Dans le cas de la NHS, on imagine bien la catastrophe possible si ces données de santé, donc hautement sensibles, avaient fuité : et pourtant, l'absence de sécurité dont témoigne la manipulation effectuée prouve qu'il s'agissait d'un cas entièrement possible.

Excel, oui, mais pour quoi faire ?

En effet, Excel permet de répondre à des besoins précis, et surtout, immédiats. Installé sur la plupart des ordinateurs fournis aux collaborateurs, il permet de créer des solutions de calculs qui demanderaient parfois des semaines de développement si ces dernières étaient industrialisées.

Pour un utilisateur unique et dans un temps limité, ce n'est pas un problème : c'est lorsque l'utilisation s'inscrit dans la durée et que les utilisateurs se multiplient. Pour la NHS, le problème n'était pas tant l'utilisation d'Excel : c'était simplement le besoin immédiat d'un outil qui n'existait pas et qui devait être aussi accessible que possible. Sans structuration et documentation précise, d'autant plus dans un cadre où, comme mentionné, la formation des utilisateurs à Excel varie énormément, le risque augmente drastiquement. C'est lorsque, en somme, Excel se substitue à des failles structurelles que le risque est le plus grand.

Dès lors que l'on s'inscrit dans la durée, donc dans un besoin fixe et un usage quotidien, Excel n'est plus adapté.

Enfin, d'un point de vue purement technique, l'utilisation d'Excel bride les capacités d'évolution et d'innovation. L’emploi d'une solution qui a vocation à offrir des fonctionnalités très générales et non forcément propres à la data est un frein important. Dans un contexte d'augmentation drastique de l'utilisation de la data et surtout de l’affinement de ses besoins, des bases de données Excel constituent un véritable obstacle.

D'abord, du fait de la taille restreinte de ces données et de leur structuration, ou absence de structuration : impossible, par exemple de mettre en œuvre des algorithmes complexes de machine learning, et encore plus avec le deep learning avec quelques milliers de données. De même, les données Excel ne sont pas structurées comme des objets mais sont structurées au mieux par des colonnes lorsqu'elles sont sous forme de tableau, au pire et dans la plupart des cas par l'emplacement de leur cellule à un moment X. On ne peut imaginer l'utilisation de traitements complexes à large échelle, notamment si l'on souhaite mettre en place une data visualisation pour des parties prenantes et des acteurs variés.

Enfin, parce qu'utiliser exclusivement Excel comme matière à l'exploitation de la data impose un lourd coût de mise à niveau lorsque l'on souhaite réellement employer des solutions data : coût de formatage, de migration, création d'environnements... Une dette technique, en somme, qu'il faudra rembourser un jour.

Ainsi, dès lors que le besoin s'inscrit dans la durée et pour un grand nombre d'utilisateurs, et surtout en fonction de la criticité des données, l'utilisation d'Excel devient un risque majeur.

Excel, oui, mais encore ?

Il apparaît donc que dans un cadre de développement de la data, l'utilisation à tout va d'Excel n'est ni une solution pérenne, sécuritaire ou même intéressante d'un point de vue purement commercial. Pour autant, se passer de ses nombreux avantages est impossible ou inenvisageable pour la majorité des entreprises. L'entre-deux, même s’il pouvait passer pour une conclusion simpliste, a toutefois ses avantages.

D'abord, lorsque le besoin est précisé et s'inscrit dans le temps, surtout s’il implique un grand nombre d'utilisateurs et encore plus si les données sont critiques à une activité, ce dernier doit impérativement quitter Excel. Et encore, même si les données n'ont pas l'air critiques au premier abord, elles le deviendront à force d'usage et d'imbrication des classeurs de données entre elles : pire encore s’il n'y a même pas de connexion simultanée.

Une des premières objections que l'on pourrait avoir à ce mode de fonctionnement est la lourdeur des développements informatiques. Toutefois, on aurait tort de se priver des solutions de no-code qui commencent à émerger et à se populariser dans les organisations. On peut par exemple penser à Power Apps, entièrement compatible avec Excel.

En outre, les solutions se démocratisent de plus en plus : il n'y a qu'à voir les multiples formations en ligne dispensées par Dataiku sur son propre site, « Dataiku academy », permettant de réaliser des manipulations complexes après quelques heures. Les éditeurs comprennent le besoin de formation que provoquent ces alternatives à Excel. Bien sûr, ces développements doivent se faire en lien avec la DSI avant d'éviter toute faille de sécurité : mais il s'agit d'un premier pas dans la récupération, la centralisation, la sécurisation et le partage des données pour des approches data plus complexes.

Pour autant, cela ne veut pas dire qu'il faut bannir entièrement Excel : la plupart des solutions permettent des exports et des récupérations de données sous format Excel. A titre collectif, cela permet une sécurisation des données mais également un meilleur partage, puisque la synchronisation des exports permet à tous de travailler sur des copies sans risquer d'altérer les sources originelles.

Évidemment, la tâche est complexe, puisqu'au-delà de la nécessité ou non, en fonction des situations, de passer sur de véritables SGBD, se pose la question de la formation des collaborateurs. Il convient d'admettre que la tâche est lourde, et le surcoût de formation aurait tendance à faire freiner des quatre fers : en revanche, le coût lié au temps perdu et aux manipulations erronées peut être d'autant plus important.

Enfin, chaque collaborateur n'a pas besoin de devenir un data analyst en puissance. En structurant correctement ses données, leur architecture et leurs différentes utilisations, on réduit déjà de manière conséquente les coûts éventuels, tant en maintien en condition opérationnelle qu'en formation des collaborateurs. Un médecin rentrant les informations d'un cas contact dans une application n'a pas besoin de connaître le fonctionnement interne de celle-ci sur le bout des doigts. Par contre, il ne faut pas qu'il soit celui chargé de développer ladite application, ou qu'on lui propose de rentrer l'historique de santé de ses patients dans un fichier accessible à tous...

La tâche est conséquente car elle va au-delà même d'Excel : elle porte, au final, sur la « culture de la donnée ». Il s'agit, en fin de compte, de celle d'un investissement, à réaliser ou non.

Le sujet vous intéresse ? Nos experts vous répondent

Avec la création d’un pôle spécialisé en Data/IA, mc2i se positionne comme un partenaire de confiance en Data Transfo au service de la démocratisation de la donnée et d’un usage responsable.