Comment garantir la qualité des données avec un volume constamment croissant ?

Depuis 2 ans, la pandémie de COVID 19 a obligé les entreprises à accélérer leur transformation digitale. Ces nombreux changements dans l'organisation du travail et la digitalisation de processus ont démultiplié le volume des données dans le monde.

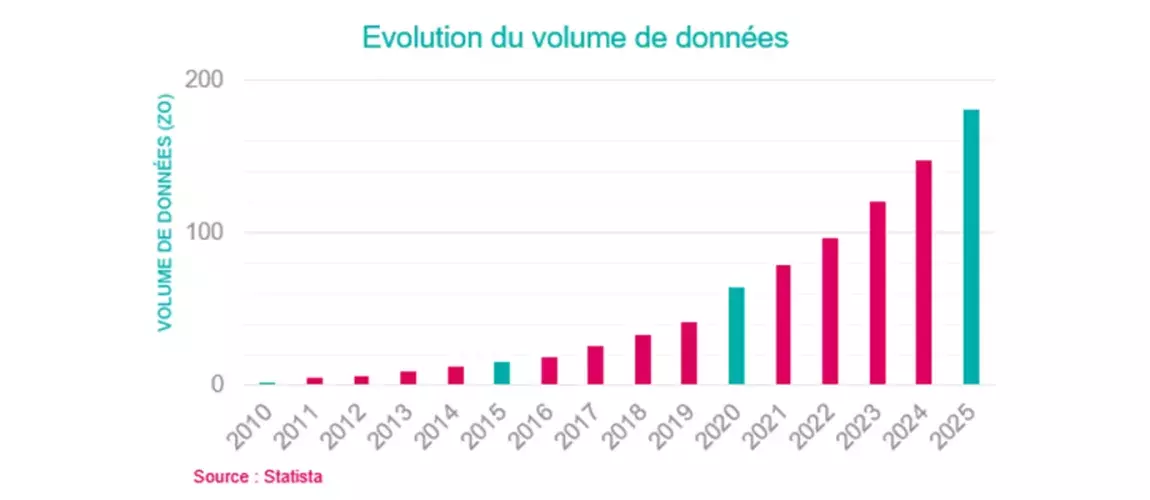

Cette tendance n’est pas nouvelle, en revanche elle connaît une forte croissance depuis 2019. D'après Statista, le volume de données a doublé entre 2019 et 2021. Les modèles prédisent un volume qui atteindra les 181 Zo (Zetta-octet soit 10^21octets) en 2025.

Challenge: la non-qualité des données

Face à cette grande quantité de données, une problématique qui a toujours été présente, s’est encore accentuée de plus belle: garantir la qualité des données.

Mais, qu’est ce que la qualité des données ? Il s’agit d’un critère d'évaluation de la donnée qui se base sur différents paramètres définis, comme la complétude, l’obsolescence, l’intégrité et la disponibilité des données. A ces critères classiques peuvent s’ajouter, selon les besoins fonctionnels de l’entreprise, des paramètres plus spécifiques répondant à des enjeux métiers et réglementaires.

Le non-respect des critères cités précédemment induit une non-qualité. Celle-ci a des conséquences importantes dont la principale est l’absence d’information permettant la prise de décisions stratégiques ou la mésinformation. Les exemples souvent rencontrés sont : la perte de visibilité sur les opportunités du marché, l’augmentation du risque de non-conformité aux réglementations et les coûts supplémentaires sur la chaîne de traitement de la donnée.

Afin d’éviter ces écueils, l’ensemble des grands acteurs français et internationaux lancent de grands programmes de transformation de leurs SI. Ces programmes sont d’autant plus stratégiques qu’ils permettent aussi de travailler sur la structuration de la donnée et donc, de maximiser la valeur apportée par ce nouvel “or noir”.

Data monitoring, une démarche proactive dans la Data gouvernance

La data gouvernance est un ensemble de pratiques visant à assurer la qualité des données avec une vision exhaustive de leur cycle de vie.

Le data monitoring est un sous-ensemble de la data gouvernance. Il rassemble des processus et technologies qui permettent de surveiller les données afin de garantir leur qualité selon l’usage fonctionnel prédéfini par l’entreprise.

Les activités de data monitoring peuvent se faire par différents acteurs à plusieurs endroits dans la chaîne de traitement de la donnée. Elles peuvent être réalisées manuellement ou automatiquement, le choix dépend de la maturité technique et des besoins des entreprises sur le sujet. A titre d’exemple: un contrôle peut être effectué à la récolte des données sources. Ce contrôle peut être réalisé par un data steward ou via un traitement automatique.

Les étapes préliminaires pour mettre en place du data monitoring

La mise en place du data monitoring doit s’inscrire dans la stratégie data de l'entreprise. Une communication claire des objectifs permettra de faire comprendre les enjeux. Le support de toutes les équipes, métiers et techniques, est nécessaire pour maximiser le rendu et procéder au changement.

Tout d’abord, il faut repérer les données structurelles pour le métier ou pour la conformité, et qui présentent des défauts en qualité pour les classifier. L’idée de cette première étape, n’est pas de traiter l’ensemble des données défectueuses de l’entreprise mais plutôt de procéder par priorité en commençant avec les données clés qui apporteront rapidement de la valeur, par exemple: les données clients.

Suite à cette récolte de données, une phase d’analyse préliminaire est effectuée pour détecter les sources de données et les potentielles causes de la non-qualité (saisie manuelle par exemple).

Une fois les causes identifiées, l’étape d'après est la définition d’actions de remédiation. Pour ce faire, il faut définir les paramètres de qualité et relever les règles fonctionnelles à faire appliquer aux objets métier, par exemple: un client ne peut pas avoir plusieurs comptes alors il faut reconnaître le profil le plus riche et supprimer le doublon (déduplication).

Enfin, il faudra penser aux solutions et actions de prévention à court terme et à moyen-long terme depuis la modification des processus de collecte de données jusqu’au changement de l’architecture data globale. L’intelligence collective, à travers des ateliers ou encore des boîtes à idées, permet de détecter facilement les “quick wins” pour simplifier la mise en place des premières phases du data monitoring.

Quelles sont les prochaines étapes ?

Dès lors que l’entreprise prendra en maturité sur le modèle de monitoring des données, des automatismes peuvent être mis en place, par exemple: envoyer des alertes aux équipes en cas de détection d’anomalies.

Dans un contexte évolutif fort des SI, ces travaux doivent être pérennisés avec une démarche d’amélioration continue, avec des sessions de rétrospectives et d’analyses de résultats qui sont nécessaires pour vérifier si l’objectif en matière de qualité est atteint. Le data monitoring mis en place sera amené à évoluer au cours du temps, avec des activités d’industrialisation et la détection de nouveaux cas d’usage.

Le sujet vous intéresse ? Nos experts vous répondent

Avec la création d’un pôle spécialisé en Data/IA, mc2i se positionne comme un partenaire de confiance en Data Transfo au service de la démocratisation de la donnée et d’un usage responsable.